robots.txt für WordPress optimieren

Brauche ich wirklich eine robots.txt?

Das Fehlen der Datei hält Suchmaschinen wie Google oder Bing nicht von der Indexierung Deiner Website ab. Die Erstellung der Datei ist aber sehr zu empfehlen, Google mag perfekt vorbereitete Seiten und so kann den Suchmaschinen auch mitgeteilt werden, was wie indexiert wird. Auch kann so definiert werden, wo die Suchmaschinen eine Sitemap finden. Eine Hinterlegung im Google Webmaster Tool entfällt so. Klare Antwort: Ja. Wenn Du noch keine robots.txt hast, empfehlen wir Dir, umgehend eine solche Datei zu erstellen.Wo ist die robots.txt?

Die Datei befindet sich in den meisten Fällen im Hauptverzeichnis von Deiner WordPress-Installation. Eine Verbindung per FTP oder SSH ist optimal, um die Datei zu erstellen und zu bearbeiten. Die Datei besteht aus reinem Text und kann somit mit einem gewöhnlichen Editor bearbeitet werden. Wenn die Datei noch nicht besteht, kann diese einfach erstellt und danach hochgeladen werden. Danach sollte der Inhalt über www.deinedomain.tld/robots.txt abrufbar sein.Wie wird die robots.txt verwendet?

Das Format der Datei ist sehr einfach gehalten. Es werden einfach Anweisungen vor einem Doppelpunkt und danach den entsprechenden Wert geschrieben. Pro Zeile wird eine Anweisung geschrieben. Hier ein kleines Beispiel:User-agent: *Prinzipiell wird immer erst geschrieben, welchen User Agent (also welchen Suchroboter) es betrifft und danach entsprechende Anweisungen, welche URLs erlaubt oder verboten sind, indexiert zu werden. Mit einem Stern wird alles eingeschlossen. Hier ein kleines Beispiel:

User-agent: * Allow: /wp-content/uploads Allow: /media Disallow: /readme.htmlIn diesem Beispiel dürfen alle Bots den uploads- sowie den media-Ordner indexieren, jedoch nicht die readme.html-Datei.

robots.txt für SEO optimieren

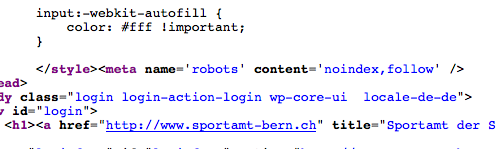

Google weist in Ihren Richtlinien darauf hin, die robots.txt nicht dafür zu verwenden, minderwertige Inhalte vor den Suchmaschinen zu verstecken. Falls Du vor hast, Archivseiten, Schlagwortseiten, etc. mit der robots.txt vor Google zu verstecken, vergiss es gleich wieder. Dafür gibt es geeignete SEO-Plugins, die diese Aufgaben auf dem geeigneten Weg erfüllen (Meta Tag noindex). Denke daran: Die Aufgabe der robots.txt ist, Crawler anzuweisen, was mit dem gefundenen Inhalt zu tun ist. Es hält die Suchmaschinenrobots nicht davon ab, Seiten und Inhalte überhaupt zu crawlen. Die Seiten wie WordPress Login und Registration müssen nicht explizit aufgeführt werden, da diese sowieso bereits mit dem noindex-Tag versehen sind. Dies kannst Du einfach im Quelltext herausfinden, bei welchen Seiten dies der Fall ist. Einfach in Deinem Browser den Quelltext anzeigen lassen und nach "noindex" suchen. Sieht dann wie folgt aus:

noindex im Quelltext

XML Sitemap zur robots.txt hinzufügen

Mit vielen SEO-Plugins wird der Link zur generierten XML-Sitemap automatisch hinzugefügt. Wenn dies fehlschlägt oder kein SEO-Plugin im Einsatz ist, kann der Link manuell eingetragen werden:Sitemap: http://www.deinedomain.tld/post-sitemap.xml Sitemap: http://www.deinedomain.tld/page-sitemap.xml

Wie sieht die ideale robots.txt aus?

Viele Seiten nutzen ganz einfache robots.txt, welche dann wie folgt aussehen können:User-agent: * Disallow: Sitemap: http://www.deinedomain.tld/post-sitemap.xml Sitemap: http://www.deinedomain.tld/page-sitemap.xmlUm aber jetzt optimiert unterwegs zu sein, kann für ein WordPress folgende robots.txt zum Einsatz kommen:

User-Agent: * Allow: /media/ Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Disallow: /readme.html Sitemap: http://www.deinedomain.tld/post-sitemap.xml Sitemap: http://www.deinedomain.tld/page-sitemap.xml Sitemap: http://www.deinedomain.tld/customers-sitemap.xml Sitemap: http://www.deinedomain.tld/team-sitemap.xmlViel Erfolg bei der Optimierung Deiner WordPress-Installation! Idee: wpbeginner.com, Bild: Shutterstock

Mehr Artikel wie dieser

Welche WordPress Version habe ich? So findest Du es heraus!

WordPress ist das beliebteste CMS der Welt, mit welchem sich neben Blogs auch ganze Webseiten erstellen lassen. Da WordPress regelmässig und fleissig verbessert wird, kann…

Weiterlesen WordPress 6.1 – Alle Neuerungen mit webP und dem neuen Twenty Twenty-Three Standard-Theme im Überblick

Das dritte grosse WordPress Update in diesem Jahr steht vor der Türe. Mit WordPress 6.1 kommen am 1. November 2022 wieder zahlreiche Neuerungen auf uns…

Weiterlesen Wie wir ACF Blocks mit Handlebars Templating einsetzen

Mittels Handlebars Templating trennen wir Logik sauber vom Inhalt. Auf diese Weise können wir übersichtliche, einfache und performante Templates für WordPress Editor Blocks erstellen, welche…

Weiterlesen iPhone Bildschirmgrössen – (k)ein Hexenwerk für Webdesigner?

iPhone-Bildschirm Messgrössen iPhone Bildschirmgrösse in Zoll (Display Size, Inches) Dies ist die Bildschirmgrösse in Zoll, gemessen von einer Ecke zur anderen. Genau so, wie auch Bildschirmgrössen von…

Weiterlesen Vorstellung von WordPress 6.0 – Neue Blöcke und mehr Performance

Seit dem 24. Mai 2022 ist mit WordPress 6.0 die zweite Hauptversion in diesem Jahr veröffentlicht worden. Benannt wurde die Version nach Jazzmusiker Arturo O’Farrill.…

Weiterlesen So kombinieren wir Nested Pages, SEO Framework & Polylang in WordPress

Bei vielen Kundenwebseiten setzen wir auf das Plugin Nested Pages, um Seitenstruktur besser sehen (und verwalten) zu können. Ohne dieses Plugin sieht die Anzeige von…

Weiterlesen WordPress Login – so bekommst Du Zugang zu Deinem Dashboard

Gerade für WordPress Anfänger, aber auch bei fortgeschrittenen Benutzern, kann es oft schwierig sein, sich bei seinem Konto anzumelden. Im folgenden Beitrag werde ich Dir…

Weiterlesen WordPress 6.0: Entwicklerteam gibt Zeitplan der neuen Version bekannt

Update: WordPress 6.0 wurde am 24. Mai 2022 veröffentlicht Wie Matias Ventura Ende Januar schrieb, soll WordPress 6.0 ein Abschluss der Phase 2 des Gutenberg-Projekts…

Weiterlesen WordPress 5.9 – Was ist neu und kommt mit dem Update

Ursprünglich sollte WordPress 5.9 (Josephine) bereits am 14. Dezember 2021 veröffentlicht werden, wurde jedoch wegen offenen Problemen nach mehrfachen Verschieben nun am 25. Januar 2022…

Weiterlesen WordPress Bilder und Medien: Alles was du wissen musst

Bilder sind ein grosser und wichtiger Bestandteil einer modernen Webseite. Sie helfen dem Besucher und Leser, Dinge zu visualisieren und lockern auch gerne lange Beiträge…

Weiterlesen Warum unsere Kunden ihre Webseite kaputt layouten können

Einleitung / Basics Bereits seit einiger Zeit haben wir unseren neuen cubetech Core im Einsatz. Intern nennen wir das Ding liebevoll „gutenbase“ – eine Mischung…

Weiterlesen Tech Talk – „Advanced Custom Fields“ Plugin

Bereits seit langer Zeit setzen wir bei unseren WordPress-Installationen auf das populäre Plugin «Advanced Custom Fields» (nachfolgend ACF). Dieser Beitrag zeigt, wie wir unsere Webseiten…

Weiterlesen